| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

Tags

- Few-shot generation

- deep learning

- Generative Model

- 디퓨전모델

- UE5

- 모션매칭

- dl

- ddpm

- Diffusion

- BERT

- motion matching

- userwidget

- WBP

- 생성모델

- multimodal

- Unreal Engine

- 폰트생성

- RNN

- NLP

- GAN

- 오블완

- WinAPI

- Font Generation

- animation retargeting

- 딥러닝

- ue5.4

- CNN

- cv

- 언리얼엔진

- Stat110

Archives

- Today

- Total

목록Transformer (1)

Deeper Learning

Attention is all you need: Transformer

Attention is all you need: Transformer

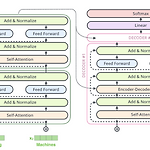

Transformer 트랜스포머 모델은 기존의 seq2seq 모델에서 Encoder, Decoder 형태를 유지하면서 RNN을 사용하지 않고 어텐션 스코어를 중심으로 학습을 하는 모델이다. 기존 Attention 모델에서 seq2seq의 Encoder가 Decoder로 정보를 전달할 때 hidden state에 정보를 모두 담기가 어렵고 시점에 따른 정보 희석의 문제를 해결하기 위해 어텐션 스코어를 사용하여 이를 보정하였다면 트랜스포머 모델은 어텐션 스코어 자체를 Encoder와 Decoder사이의 연결점으로 사용한다. Multi-head-Self-Attention 트랜스포머 모델은 셀프 어텐션을 통해 계산한 어텐션 스코어를 사용하기 때문에 먼저 셀프 어텐션에 대해 알아보겠다. 셀프 어텐션은 한 문장에서..

AI/Deep Learning

2021. 10. 10. 00:00