| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- Font Generation

- NLP

- BERT

- WBP

- UE5

- 폰트생성

- Few-shot generation

- 생성모델

- Stat110

- 디퓨전모델

- animation retargeting

- deep learning

- ddpm

- 모션매칭

- multimodal

- 오블완

- motion matching

- 딥러닝

- RNN

- Unreal Engine

- ue5.4

- CNN

- Diffusion

- GAN

- Generative Model

- WinAPI

- cv

- userwidget

- dl

- 언리얼엔진

- Today

- Total

목록생성모델 (9)

Deeper Learning

LDM: High-Resolution Image Synthesis with Latent Diffusion Models

LDM: High-Resolution Image Synthesis with Latent Diffusion Models

Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, Björn Ommer, (2021.12) [Ludwig Maximilian University of Munich & IWR, Heidelberg University, Runway ML] (이전 Diffusion Models paper review(DDPM, DDIM, Improved-DDPM 등)에서 다루었던 중복된 내용은 자세하게 적지 않았음) Abstract Diffusion model은 이미지 생성에서 좋은 성능을 보였고 재학습 없이 guidance를 주어 이미지 생성 프로세스를 조정할 수 있는 능력 또한 갖추고 있다 하지만 pixel level에서의 연산이 이루어지기 때문에 수백일의..

Diffusion Models Beat GANs on Image Synthesis

Diffusion Models Beat GANs on Image Synthesis

Prafulla Dhariwal, Alex Nichol, (2021.05) [OpenAI] Abstract Diffusion 모델이 현재 SOTA 생성 모델을 뛰어넘는 샘플 이미지 퀄리티를 달성할 수 있음을 본 논문에서 소개 unconditional image 생성에서는 Ablation study를 통해 찾은 더 나은 아키텍처를 적용하였고 conditional image 생성에서 classifier의 gradient를 활용하여 더 좋은 샘플 퀄리티와, fidelity & diversity trade-off를 조정할 수 있는 classifier-guidance를 제시 Diffusion 모델의 장점은 distribution coverage를 유지한 채 25 forward step만으로도 BigGAN-deep..

Few-Shot Unsupervised Image-to-Image Translation

Few-Shot Unsupervised Image-to-Image Translation

Ming-Yu Liu, Xun Huang, Arun Mallya, Tero Karras, Timo Aila, Jaakko Lehtinen, Jan Kautz, [NVIDIA, Cornell University, Aalto University] (2019.05) Abstract Unsupervised image-to-image(i2i)는 여러 class 간 매핑을 학습하는 방법 최근 방법론들은 좋은 성과를 보였으나 학습과정에서 많은 수의 소스, 타깃 이미지를 필요로 하는 문제가 존재 인간은 매우 적은 수의 이미지로도 object를 잘 파악하는데에서 영감을 받아 few-shot 연구를 진행 저자는 새로운 모델 아키텍처, adversarial 학습 scheme을 함께 사용하여 few-shot generatio..

Few-Shot Font Generation by Learning Fine-Grained Local Styles

Few-Shot Font Generation by Learning Fine-Grained Local Styles

Licheng Tang, Yiyang Cai, Jiaming Liu, Zhibin Hong, Mingming Gong, Minhu Fan, Junyu Han, Jingtuo Liu, Errui Ding, Jingdong Wang [Baidu Inc, University of California, Berkeley, University of Melbourne] (2022.05) Abstract **Few-shot font generation(FFG)**는 노동 cost를 크게 줄여주어 주목을 받고 있는 기술 이전의 연구들은 reference glyph의 content와 style을 global, component-wise하게 disentangle 하는 방식으로 FFG에 접근 하지만 glyph의 style은 ..

VQ-VAE: Neural Discrete Representation Learning

VQ-VAE: Neural Discrete Representation Learning

Aaron van den Oord, Oriol Vinyals, Koray Kavukcuoglu, Deepmind. (2017.11) Abstract unsupervised로 유용한 representation을 학습하는 것은 머신러닝에서 쉽지 않다 discrete representation을 학습하는 간단하고 강력한 generative model: Vector Quantised Variational Autoencoder(VQ-VAE)를 제시 encoder의 output이 discrete, prior가 static이 아닌 학습된다는 점이 VAE와의 차이점 discrete representation 학습을 위해 vector quantisation(이하 VQ)을 활용 VQ는 posterior collapse를 ..

GAN: Generative Adversarial Nets

GAN: Generative Adversarial Nets

Ian J. Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, David Warde-Farley, Sherjil Ozair, Aaron Courville, Yoshua Bengio, Universite de Montreal (2014.06) Abstract 데이터 분포를 파악하는 generative model G와 sample이 training data에서 온 것인지 생성된 것인지 판별하는 discriminator D를 적대적인 프로세스로 동시에 학습하는 생성모델 프레임워크를 제시 G는 D가 제대로 판별하지 못하도록 학습되는 minimax two-player game G와 D는 MLP로 구성하였으며 역전파를 통해 학습이 가능한 모델 Ma..

VAE: Auto-Encoding Variational Bayes

VAE: Auto-Encoding Variational Bayes

Diederik P. Kingma, Max Welling, Machine Learning Group Universiteit van Amsterdam. (2013) Abstract intractable posterior, large dataset, continous latent variable 환경에서 directed probabilistic model의 추론, 학습을 어떻게 효율적으로 할 수 있을까? mild 한 미분 가능 조건하에 intractable case에서도 가능하며 large dataset을 다룰 수 있는 stochastic variational inference와 학습 알고리즘을 제시 Contribution variational lower bound에 reparameterization을 적용..

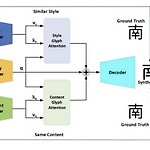

GANet: Glyph-Attention Network for Few-Shot Font Generation

GANet: Glyph-Attention Network for Few-Shot Font Generation

Under review as a conference paper at ICLR 2022 Mingtao Guo, Wei Xiong, Zheng Wang, Yong Tang, Ting Wu. Xian Univ. (2021.09) Abstract Non-local neural network에서 영감을 받아 제시한 GANet content encoder와 style encoder는 content glyph과 style glyph에서 key와 value를 추출 기존 SOTA few-shot font 생성 모델을 뛰어넘는 결과 Introduction 중국 폰트에 대한 인기가 세계적으로 증가하면서 니즈또한 증가하고 있음 그러나 폰트 생성은 노동집약적이며 오랜시간이 걸림 image to image translation과..

StyleGAN: A Style-Based Generator Architecture for Generative Adversarial Networks

StyleGAN: A Style-Based Generator Architecture for Generative Adversarial Networks

Tero Karras, Samuli Laine, Timo Aila. NVIDIA. (2019.03) Abstract style transfer 논문의 아이디어를 차용한 아키텍처를 제시 새 아키텍처는 비지도 학습으로 자동으로 학습되며, high-level attributes(pose, identity)와 생성 이미지의 stochastic variation(주근깨, 머리카락)을 separation, 직관적인 scale에 따른 생성 이미지 조정 또한 가능 기존 distribution quality metrics에서 SOTA를 달성, 입증 가능한 더 나은 interpolation 성능, variation의 latent factor를 더 잘 disentangle interpolation 퀄리티와 disentang..